Много блогъри търсят отговора на този въпрос: „Как да се отървем от дублиращите се страници?“, За да премахнат дублиращите се страници на своя сайт от резултатите от търсачките. Дублиращите страници попадат в индекса на търсачките, където присъстват заедно с основната популяризирана страница.

Може да има много такива страници, в същото време търсачката ще трябва да класира същите страници в резултатите от търсенето. За това търсачката може да наложи санкции на основната страница, като я понижава в резултатите от търсенето. По този начин, дублираните страници имат вредно въздействие върху популяризирането на страниците на сайта в търсачката.

Съдържание:- Моята история за заснемане на дублирани страници

- Търсене на дублирани страници

- Забрана на индексирането във файл robots.txt

- Добавяне на параметъра replytocom към инструменти за уеб администратори

- WordPress Тема за коментар на тема за дърво коментари

- WordPress SEO плъгин от Yoast за премахване на replytocom

- 301 пренасочване за премахване на replytocom

- Настройки за SEO плъгини

- Ръчно премахване на дублирани страници

- Как се изтриват дубликати в моя сайт

- Друг начин за справяне с дублирани страници

- Изводи на статията

Дублиращите страници могат да копират цялото съдържание или само частично съдържание на главната страница. По-специално, самият WordPress CMS създава в някои случаи дублиращи се страници, например, добре познатия „replytocom“ (коментар, отговор на коментар, реплика).

Ако коментарите на дървото са включени на вашия сайт, тогава в този случай всеки коментар ще създаде дубликат на страницата. Следователно, ако в индекса на търсачките присъстват дублирани страници на даден сайт, тогава е необходимо тези страници да бъдат премахнати от резултатите на търсачките.

Наличието на дублирани страници в търсенето вреди на сайта, когато се популяризира в търсачките. Търсачките понижават позицията на сайта, така нареченото тегло на страницата намалява, индексирането на сайта се влошава и т.н..Търсачката на Google обръща специално внимание на наличието на дублирани страници, понижавайки позицията на сайта при наличието на голям брой от тях. Повече няма да теоретизирам по тази тема, а по-скоро ще ви разкажа как се боря с дублиранията на страници, използвайки примера на моя сайт - vellisa.ru.

Моята история за заснемане на дублирани страници

В самото начало на пролетта на 2013 г. сайтът ми навърши една година, по това време трафикът на сайта беше приблизително 2000 посетители на ден. Тогава трафикът към обекта започна да намалява. Още в средата на май посещаемостта едва надвишава 1000 посетители на ден..

През пролетта на 2013 г. много блогъри, поради въвеждането на нови алгоритми, намаляха посещаемостта от Google. На моя сайт трафикът от търсачката Google намаля с около 40%. В моя случай спадът на трафика беше повлиян от въвеждането на нови алгоритми, както и някои промени, които направих по това време на моя сайт.

Мислейки, реших да върна предишния трафик за моя сайт. През лятото изпълних тази задача, през септември сайтът ми отново успя да достигне среден трафик от 2000 посетители на ден. Освен това трафикът към моя сайт продължи да се увеличава..

Всичко изглежда наред, но факт е, че ръстът на посещаемостта се случи главно поради търсещата машина Yandex. Ако по-рано съотношението на посетителите, дошли на сайта от Yandex и Google търсене, беше 3 към 1 (приблизително съотношение, приблизително) в полза на Yandex, което приблизително съответства на дела на търсачките в Runet, тогава това съотношение се увеличи до 5 до 1. Имаше силна зависимост от една търсачка.

Посещаемостта от Google нарасна много бавно, едва през пролетта на 2014 г. тя достигна нивото от миналата година. Но по това време, цяла година, пишех нови статии. Оказва се, че Yandex реагира адекватно на добавянето на нови статии в сайта, което не може да се каже за Google.

През декември 2013 г. трябваше да инсталирам нов шаблон на сайта си, тъй като в предишната тема не можах да променя структурата на моя сайт. И без това трябваше да направя тези действия.

След това обърнах внимание на дублиращите се страници в индекса на търсачките. Преди това знаех за този проблем, прочетох за начините за решаването му, но все още не съм направил нищо..

Във всеки случай не бих изключил коментарите на дърветата на моя сайт, защото поради това би било неудобно за посетителите на сайта и не исках да използвам приставки за премахване на дублирани страници.

В резултат на това кодът беше инсталиран във файла htaccess и някои директиви бяха премахнати от файла robots.txt (ще ви разкажа повече за това, което направих по-долу). Постепенно броят на дублираните страници на моя сайт намаля в резултатите от търсачките.

През март 2014 г. добавих параметъра „replytocom“ към инструментите за уеб администратори на Google, а през май добавих още един параметър там: „feed“.

В момента на моя сайт нямаше дублирани страници в резултатите на търсачката Google, които имат променливия replytocom по свой адрес, но преди това имаше огромен брой такива страници (няколко хиляди).

Накрая останах приятно изненадан от увеличението, около 2 пъти посещаемостта от Google. Сега съотношението между търсачките стана около 2 към 1 в полза на Yandex.

Така от моя собствен опит научих какъв ефект може да има върху промоцията на уебсайтове, наличието на дублирани страници в индекса на търсачката.

Вярно е, че ще е необходимо да се вземе предвид, че търсачките класират страници в резултатите от резултатите от търсенето по много начини. Следователно може да нямате значително увеличение на трафика към вашия сайт. Във всеки случай премахването на дублирани страници от резултатите от търсенето ще има благоприятен ефект върху вашия сайт..

Търсене на дублирани страници

За да търсите дублирани страници на вашия сайт, въведете израза „site: vellisa.ru“ в полето за търсене (вместо „vellisa.ru“ въведете името на вашия сайт). Отидете на последната страница с резултати от търсенето, аз в случая имам 19 страници. Запомнете номера на тази страница, за да можете по-късно бързо да отидете на тази страница.

На последната страница с резултати от търсенето, под последния резултат от резултатите от търсенето, ще видите съобщение, в което сте информирани, че търсачката е скрила някои резултати, които са много подобни на вече представените по-горе. След това кликнете върху връзката "Покажи скрити резултати".

След това първата страница с резултати от търсенето ще бъде отворена отново. Отидете направо на страницата, която си спомняте, в моя случай това е страница 19. На тази или на следващата страница ще видите дублирани страници на вашия сайт.

Това изображение показва дублирани страници, които имат връзки „feed“ и „tag“ в URL адреса. Също така в резултатите от търсенето може да има дубликати с "replytocom", "page" и с някои други параметри.

Друг голям проблем, ако сайтът използва коментари на дърво, е огромният брой страници с променливата replytocom, генерирана от самия WordPress CMS.

Можете да проверите наличието на страници с replytocom по този начин: въведете израза „site: vellisa.ru replytocom“ (без кавички) в лентата за търсене на Google. Вместо "vellisa.ru" поставете името на вашия сайт.

На моя сайт няма дублирани страници с replytocom, въпреки факта, че на моя сайт има коментари на дървета. Като пример ще взема сайта на една моя приятелка Джулия (inet-boom.ru), надявам се, че няма да се обиди за това.

В това изображение, в самия край на връзката, след адреса на страницата, ще видите края на връзката - "? Replytocom = 3734". Номерата в края на адреса ще се променят в зависимост от номера на коментар.

В индекса на търсачките може да има огромен брой такива страници. Следователно, отговорът ще трябва да се бори с приема.

Какво ще трябва да се направи?

- Проверете за дублиращи се страници в индекса на търсачките.

- Затворете необходимите параметри от индексирането във файл robots.txt.

- Добавете настройки към лентата с инструменти на Google Webmaster.

Тези изисквания ще трябва да бъдат изпълнени без провал. Останалите действия ще зависят от метода, който решите да се борите срещу дублирания на страници..

Ще трябва да добавите уебсайта си към инструментите за уеб администратори на Google и Yandex, за да решите проблема с премахването на дублиращи се страници с помощта на тези инструменти за търсачки..

Забрана на индексирането във файл robots.txt

За да се забрани индексирането на определени параметри, които влияят на появата на дублирани страници при търсенето, директивите се добавят към файла robots.txt. Когато използвате директивата Disallow, се дава команда за търсене на роботи, които да забранят индексирането.

Командите за предотвратяване на индексирането във файла robots.txt може да изглеждат подобно (в този пример част от файла):

Директиви с въпросителен знак (?) Обикновено присъстват, ако на сайта се създават така наречените CNC връзки, чрез които се променя URL адресът на уеб страницата. Има и команда за забрана на индексирането на връзки с променливата replytocom.

Ако търсачката Yandex по принцип отговаря на директивите, въведени във файла robots.txt, тогава с търсачката Google всичко е много по-сложно. Роботите от Google индексират всичко, въпреки забраните, посочени във файла robots.txt.

Плъгинът за SEO оптимизация има възможност за затваряне на заглавието, маркерите, архивите, страниците за търсене и т.н. с етикета "noindex". Вярно е, че тези инструкции не винаги са следвани от роботи за търсене.

Добавяне на параметъра replytocom към инструменти за уеб администратори

В инструмента за уеб администратори на Google отидете на страницата Инструменти за уеб администратори. В дясната колона "Toolbar" на сайта първо кликнете върху бутона "Сканиране" и след това върху бутона "Настройки на URL адреса".

На тази страница можете да добавите нови параметри или да промените вече добавени такива за обработка от роботи за търсене с Google. В зависимост от настройките, роботът на Googlebot ще игнорира определени параметри при въвеждане на страници на сайта в индекса на търсачката.

- За да добавите нов параметър, кликнете върху бутона "Добавяне на параметър".

- След това се отваря прозорецът "Добавяне на параметър"..

- В полето на параметъра (чувствително към регистъра) добавете нов параметър, в този случай "replytocom".

- На въпроса: „Променя ли този параметър съдържанието на страницата, която потребителят вижда?“, Вие отговаряте: „Да, параметърът променя или реорганизира или ограничава съдържанието на страницата“.

- Когато отговаряте на въпроса: „Как този параметър влияе върху съдържанието на страницата?“, Изберете опцията за отговор: „Друго“.

- На въпроса: „Кои URL адреси, съдържащи този параметър, трябва да обхожда Googlebot“, отговорете: „Няма URL адреси“.

- След това кликнете върху бутона "Запазване".

По същия начин можете да добавите и други параметри. Ако параметърът вече е в списъка, тогава за да промените настройките му, ще трябва да кликнете върху връзката "Промяна".

След като добавите параметъра replytocom към панела за уеб администратори, ще трябва да премахнете нещо като директивата „Disallow: / *? Replytocom“ (ако присъства във файла на робота) от файла robots.txt, така че googlebot следва връзките с този параметър и изтрива ги от индекса.

Ако вашият сайт няма дублирани страници с този параметър, тогава можете да оставите такава директива във файла robots.txt.

Постепенно дублираните страници ще бъдат премахнати от индекса на търсачката. Ако има много дублирани страници, тогава в този случай процесът на премахване на дублирани страници ще отнеме доста дълго време, вероятно дори в рамките на няколко месеца.WordPress Тема за коментар на тема за дърво коментари

Тъй като появата на replytocom се улеснява от коментарите на дърветата, някои потребители обикновено ги деактивират на своя сайт. След деактивиране на коментарите на дърветата, особено ако статиите в сайта се коментират активно, се получава много неудобна навигация. За посетителя понякога изобщо не е ясно кой, къде, на кого, какво отговори.

Плъгинът за коментар на тема на WordPress решава проблема с коментарите на дървото в WordPress. Коментарите на дърветата остават на сайта, без добавени променливи в отговора. Плъгинът показва връзка с коментар чрез javascript, така че търсачките не индексират тази връзка.

Новите променливи replytocom вече няма да се показват в индекса на търсачката, а старите променливи ще трябва постепенно да бъдат премахнати от индекса на търсачката.

На мен лично не ми хареса външния вид на коментарите в тази приставка. Не използвах този плъгин на моя сайт. Отбелязвам, че плъгинът WordPress Thread Comment за борба с replytocom беше препоръчан от Александър Борисов.

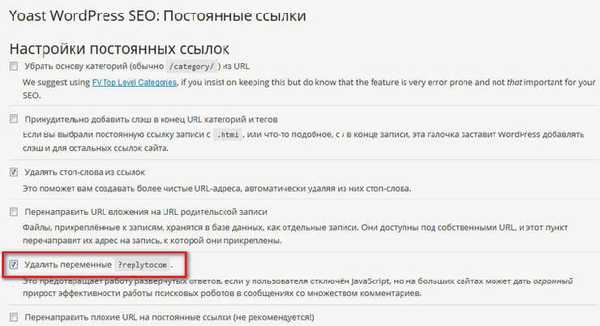

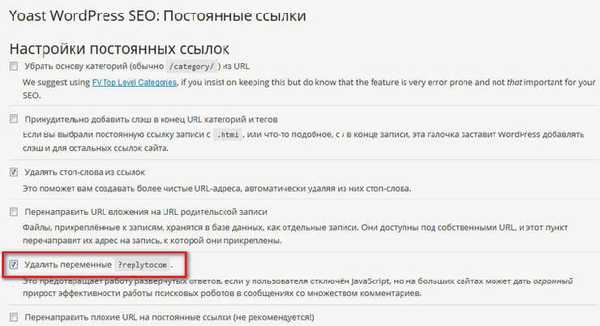

WordPress SEO плъгин от Yoast за премахване на replytocom

WordPress SEO от Yoast плъгин, доста мощен плъгин за оптимизация на SEO сайтове, наред с други неща, ви позволява да премахнете променливите на replytocom от сайта. В същото време коментарите на дърветата ще останат на вашия сайт.

След като инсталирате приставката за WordPress SEO от Yoast на вашия уебсайт, в настройките на приставката, в секцията „Препратки към линкове“, ще трябва да активирате „Изтриване на променливите?.

След това постепенно дублиращите се страници с „сопот” отговор ще бъдат премахнати от индекса на Google.

Тъй като на моя сайт е инсталиран приставката за всичко в едно SEO Pack и по някаква причина, все още не искам да премина към WordPress SEO от Yoast плъгин, не използвах тази опция за борба с дублирания на страници..

301 пренасочване за премахване на replytocom

Това е може би най-радикалният начин за справяне с replytocom. Използвах този конкретен метод.

След като промени шаблона, Лариса Web-Cat предложи да използвам 301 пренасочвания за борба с отговорите. Преди да променя шаблона в сайта, не посмях да използвам този метод.

Сега мога да кажа, че когато използвам пренасочването 301, а също и след някои действия, за които ще пиша по-долу, моят сайт успешно се справи с дубликати replytocom.

На това изображение можете да видите, че на моя сайт няма дублирани страници с променливата replytocom, въпреки факта, че на моя сайт има коментари на дървета, без да използвате специални приставки.

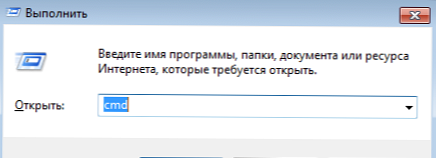

За да използвате пренасочването 301, ще трябва да поставите специален код във файла "htaccess", който се намира в основната папка на вашия сайт. Коренната папка на сайта е папката на вашия сайт, която съдържа папките "wp-admin", "wp-content", "wp-include" и т.н..

Във файла htaccess, под реда "RewriteBase /", ще трябва да поставите следния код:

RewriteCond% QUERY_STRING replytocom = RewriteRule ^ (. *) $ / $ 1? [R = 301, L]Внимание! Преди да вградите този код, оригиналния htaccess файл на вашия компютър. Ако направите грешка, нещо се обърка, тогава можете да замените модифицирания htaccess файл с оригиналния файл с помощта на файловия мениджър на вашия хостинг или чрез FTP с помощта на програмата FileZilla.

Ако възникне проблем, вместо вашия сайт можете да видите „бял екран на смъртта“. Замяната на променения файл с оригиналния htaccess файл ще възстанови функционалността на вашия сайт.

След като поставите кода, ще трябва да проверите работата на пренасочването 301. За да направите това, първо ще трябва да поставите връзка в съдържащия отговорен адрес в адресната лента на браузъра и след това да проверите резултата от прехода. След прехода връзката на отворената уеб страница ще трябва да се промени към оригиналната връзка, която не съдържа променливата replytocom в URL адреса.

След това ще трябва да направите още две неща. Първо, ще трябва да премахнете директиви от файла robots.txt, съдържащ забрана за индексиране на страници с въпросителен знак. Директивите се изтриват, ако използвате този метод..

След това ще трябва да добавите параметъра replytocom към „Google Инструменти за уеб администратори“, както писах по-горе в статията.

Настройки за SEO плъгини

За да предотвратите индексирането на архивни страници, категории, маркери, 404 страници, страници за търсене, страници за страници (навигация по страница), в приставката за всичко в един пакет ще трябва да активирате елементи за добавяне на аргументи noindex, follow и noindex, nofollow (за навигация по страница).

В приставката за WordPress SEO от Yoast параметрите за индексиране за търсачките ще изглеждат така: noindex, следвайте.

Сега трябва да сте търпеливи и да изчакате Google да премахне дублиращите се страници от своя индекс. Ако не искате да чакате дълго или ако на вашия сайт са останали много малко дублирани страници, тогава можете да ускорите премахването им.

Ръчно премахване на дублирани страници

Можете ръчно да добавите връзки към дублиращи се страници към Инструменти за уеб администратори, за да ги премахнете от индекса на търсачката. Когато в резултатите от търсачката не бяха оставени толкова много дублирани страници в моя сайт, аз също ръчно добавих намерените резултати, за да ги премахна по-бързо от индекса.

- На страницата „Инструменти за уеб администратори“, в дясната колона на „Toolbar“ на сайта, първо кликнете върху бутона „Google Index“ и след това върху бутона „Изтриване на URL адреси“.

- След това се отваря страницата „Изтриване на URL адреси“. На тази страница ще трябва да кликнете върху бутона "Създаване на нова заявка за изтриване".

- Под бутона ще се отвори поле, в което да се вмъкне връзка. След това ще трябва да кликнете върху бутона "Продължи".

- След това се отваря нова страница, на която ще се показва изтритият URL адрес. В елемента „Причина“ изберете тази опция: „Изтрийте страницата от резултатите от търсенето и от кеша“. След това кликнете върху бутона "Изпращане на заявка".

- На страницата Изтриване на URL адреси ще видите добавени връзки, които чакат да бъдат изтрити. Точно по този начин можете да добавите следната връзка, за да я премахнете от резултатите от търсенето и от кеша на търсачката Google.

Проблемът съществува, той може да има отрицателно въздействие върху промоцията на уебсайтове, така че администраторът на сайта ще трябва да се отърве от дублиращите се страници, за да получи положителен резултат.

Измина месец от публикуването на тази статия, сега е време да я допълним с нова информация.

Как се изтриват дубликати в моя сайт

Сега ще ви разкажа как точно в момента се води борбата срещу дублиращите се страници на моя сайт.

- Премахнах някои забранителни директиви от файла robots.txt, за да позволя на ботовете за търсене достъп до определени директории на моя сайт.

- В приставката за SEO оптимизация (AIOSP) отбелязах точки за добавяне на роботи с мета етикет за съответните страници на сайта. Ароматизатор, който се премества на такава страница, ще види забраняващ мета маркер и няма да индексира тази страница.

За целта беше отворен достъпът до определени страници във файла за роботи, така че роботът отиде на тази страница и видя следните мета тагове:

meta name = "robots" content = "noindex, nofollow" meta name = "robots" content = "noindex, следвайте"

Следователно роботът за търсене няма да индексира страницата с такива мета тагове. По-ранните посещения в индекса на страниците ще бъдат постепенно премахвани от резултатите от търсачките..

- Опциите за отговори са добавени към панела за уеб администратори на Google.

- Добавих следния код към htaccess файла:

RewriteCond% QUERY_STRING replytocom = RewriteRule ^ (. *) $ / $ 1? [R = 301, L] RewriteRule (. +) / Емисия / $ 1 [R = 301, L] RewriteRule (. +) / Страница с коментари / $ 1 [R = 301, L] RewriteRule (. +) / Trackback / $ 1 [R = 301, L] RewriteRule (. +) / Коментари / $ 1 [R = 301, L] RewriteRule (. +) / Прикачване / $ 1 [R = 301, L] RewriteCond% QUERY_STRING ^ attachment_id = [NC] RewriteRule (. *) $ 1? [R = 301, L]

Този код включва 301 пренасочвания с replytocom, както и пренасочвания с други параметри, които взех от сайта на Александър Борисов. Както разбирам, автор на пренасочвания за други параметри е известният блогър Александър Алаев (Алаич).

Съответните директиви (емисия, коментари, проследяване и т.н.) за параметри, добавени към htaccess файла, бяха изтрити от файла robots.txt.

След това роботът за търсене, който отива на дублирана страница, която има такива параметри в URL адреса, ще бъде пренасочен с помощта на пренасочване 301 към оригиналната страница на моя сайт.

- Към файла function.php беше добавен код, за да се предотврати появата на нови снимки с replytocom, които бяха намерени в Интернет от посетител на моя сайт, Антон Лапшин:

функция change_reply_to_com ($ link) return preg_replace ('/href=\'(.*(\?|&)replytocom=(\d+)# reply)/', 'href = \' # comment- $ 3 ', $ link ); add_filter ('comment_reply_link', 'substitu_reply_to_com');Ще трябва ли да поставите този код във файла "Функции на тема" (функции.php) преди затварящия маркер?>.

След като поставите кода, когато задържите курсора на мишката върху бутона „Отговор“ в коментарите, променливата responsetocom вече няма да се показва в връзката, която ще се вижда в долния ляв ъгъл на прозореца на браузъра. Следователно нови връзки с този параметър няма да се добавят към индекса на търсачките.

Преди да направите промени, не забравяйте да архивирате файла Тематични функции..

Всички тези настройки работят главно за търсачката Google. В Yandex съотношението на броя на страниците, заредени от робота, и страниците в търсенето на моя сайт в момента е оптимално.

Друг начин за справяне с дублирани страници

Намерих в Интернет друг начин за премахване на дублирани страници от резултатите от търсенето. Използвайки кода, мета таговете роботи noindex, nofollow ще бъдат добавени към определени страници на сайта, за да забранят индексирането на такива страници.

Този код се вмъква във файла function.php веднага след това

функция meta_robots () ако (is_archive () или is_category () или is_feed () или is_author () или is_date () или is_day () или is_month () или is_year () или is_tag () или is_tax () или is_attachment () или is_paged () или is_search ()) echo "". ''. "\ n"; добавяне на управление ('wp_head', 'meta_robots');След като добавите този код, в приставката за SEO оптимизация ще трябва да деактивирате добавянето на мета маркера Robot към тези страници. В приставката за всичко в едно SEO Pack - раздел „Настройки за индексиране (noindex)“.

Тогава ще бъде необходимо да премахнете съответните директиви за забрана от файла на роботите..

По този начин можете да затворите необходимите страници от индексирането. Само за да се отървете от дублиращия се отговорник, трябва да използвате един от методите, описани в тази статия. В допълнение към използването на пренасочвания и плъгини, ще бъде възможно и да се затворят връзки от коментари в span маркер, така че да не бъдат индексирани от търсачките.

След като завършите настройките, от време на време ще трябва да наблюдавате процеса на премахване на дублиращи се страници от вашия сайт.

Изводи на статията

Уеб администраторът трябва да обърне внимание на наличието на дублирани страници на сайта и ако те бъдат намерени, предприеме мерки за премахването им от резултатите от търсенето, тъй като те се отразяват негативно на популяризирането на сайта. Поради това сайтът може да бъде подложен на санкции на търсачките..

Свързани публикации:- Как да прехвърлите сайт към HTTPS

- Как да увеличите трафика на уебсайтове

- Как да инсталирате реклами в сайта

- Преглед на бърз хостинг на AdminVPS

- Плъгин за хляб NavXT - галета за сайта